Este evento já decorreu.

Aplicações: Inteligência Artificial

Aplicações: Inteligência Artificial

Inteligência Artificial: Aplicações, o primeiro debate do ciclo, apresenta o estado atual de algumas das principais aplicações da inteligência artificial, as suas possibilidades e os seus limites.

Como ponto de partida vão ser abordadas grandes áreas de investigação como os robôs com quem já podemos conversar e as possibilidades do processamento da língua natural e dos agentes conversacionais; o uso da inteligência artificial e de multiagentes robóticos para o bem social; a inteligência artificial nas implementações de sistemas de segurança e no combate de fraudes informáticas e outras.

17 ABR 2019

QUA 16:00

Entrada gratuita*

Duração 2h

*Entrada gratuita, sujeita à lotação e mediante levantamento de bilhete no próprio dia a partir das 15:00

Em português e inglês com tradução simultânea

Live streaming aqui

Biografias Inteligência Artificial: Aplicações

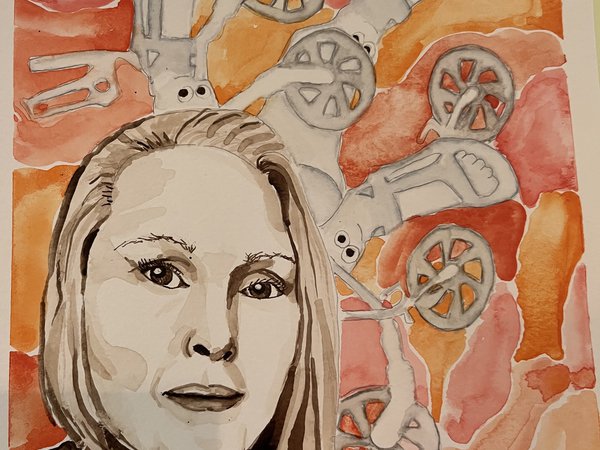

Luísa Coheur (ist, portugal)

Luísa Coheur nasceu em Lisboa, adora ensinar e é uma apaixonada por boas histórias. É licenciada em Matemática Aplicada e Computação pelo Instituto Superior Técnico (IST), e doutorada pelo IST e pela Université Blaise-Pascal na área de processamento da língua Natural. É professora do Departamento de Engenharia Informática do IST e investigadora no INESC-ID. O seu tópico de estudo de eleição recai sobre as interfaces em língua natural. Como acredita que a ciência deve estar ao serviço do bem público, está a desenvolver, entre outros, um tradutor de português para língua gestual portuguesa, bem como software que permite criar exercícios que possam auxiliar crianças com necessidades especiais. Quando tem tempo (no Verão) escreve. Tem três livros e dois contos (não científicos) publicados.

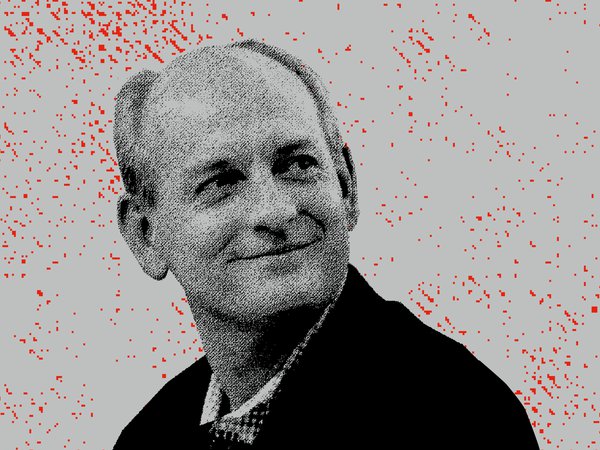

Milind Tambe (India e EUA)

Milind Tambe é Professor Helen N. e Emmett H. Jones de Engenharia na Universidade do Sul da Califórnia (USC) e Co-Diretor Fundador do CAIS, o Centro de Inteligência Artificial da USC, onde centra sua pesquisa no avanço de inteligência artificial e de multiagentes para o bem social. Doutorado pela Escola de Ciência da Computação da Universidade Carnegie Mellon, é membro da AAAI (Associação para o Avanço da Inteligência Artificial) e da ACM (Associação de Máquinas de Computação). Prof. Tambe contribuiu com vários artigos fundamentais em inteligência artificial em áreas como a dos agentes inteligentes e a teoria de jogos computacional; esses trabalhos teóricos receberam mais de uma dúzia de prémios em congressos como AAMAS, IJCAI, IAAI e IVA. Além disso, o Prof. Tambe é pioneiro no mundo real de implementações de jogos de segurança, o que o levou e à sua equipa a receber elogios do Comandante da Guarda Costeira dos EUA, da Polícia do Aeroporto de Los Angeles, e dos Federal Air Marshals Service dos EUA. Recebeu o prémio International Joint Conference on AI John McCarthy Award, Prémio de Pesquisa de Agentes Autônomos da ACM/SIGAI, o prémio Christopher Columbus Fellowship Foundation Homeland Security, o prêmio INFORMS Wagner em Pesquisa Operacional, o Rist Prize da Military Operations Research Society, o IBM Faculty Award, o prêmio fundação Okawa, o prêmio de desafio científico RoboCup, entre outros. Por seu ensino e tutoria, o Prof. Tambe recebeu o prêmio USC Steven B. Sample Teaching and Mentoring, entre outros. Prof. Tambe co-fundou uma empresa baseada na sua investigação, a Avata Intelligence.

Pedro Bizarro (Feedzai, Portugal e EUA)

Pedro Bizarro é cofundador e Chief Science Officer da Feedzai. Iniciando o seu percurso na academia e na investigação, Pedro Bizarro transformou a sua experiência técnica em sucesso empresarial, ao ajudar a desenvolver a plataforma de inteligência artificial com que a Feedzai opera, sendo líder no combate a fraudes. Pedro Bizarro é membro oficial do Forbes Technology Council, professor visitante da Carnegie Mellon University, bolseiro da Fulbright, e trabalhou com o CERN (Organização Europeia para Pesquisa Nuclear). É doutorado em Ciência de Computação pela Universidade de Wisconsin, Madison.

Sinopses Inteligência Artificial: Aplicações

DEBATE - 17 de Abril, 16h00 – 18h00 – Grande Auditório

Luisa Coheur (IST, Portugal), Pedro Bizarro (Feedzai, Portugal e EUA), Millind Tambe (India e EUA)

Luísa Coheur professora do Departamento de Engenharia Informática do IST e investigadora no INESC-ID

Nesta palestra, Luísa Coheur irá falar-nos sobre o processamento da linguagem natural, uma das grandes áreas da inteligência artificial e, em particular, sobre os agentes conversacionais, hoje em dia mais conhecidos por "chatbots". O que está por detrás de um chatbot? Será que nos compreendem mesmo? Da velhinha ELIZA (o primeiro chatbot de sempre, criado nos anos 60) às atualmente superfamosas assistentes virtuais Siri, Cortana e Alexa, o que mudou? Quais foram os desafios superados? O que ainda está por resolver? O que é real e o que é ficção científica? Será que alguma vez conseguiremos dominar algo tão complexo como a língua que falamos? Estas são as perguntas a que Luísa Coheur tentará responder.

Pedro Bizarro, co-fundador e Chief Science Officer da Feedzai

Instituições financeiras globais, bancos, processadores de pagamentos e plataformas de e-commerce, todos eles têm uma coisa em comum: o nível de ameaça aumentou drasticamente com o surgimento de tecnologia sofisticada usada para conduzir atividades fraudulentas. Pedro Bizarro, co-fundador e CSO da Feedzai explicará como a IA tem um papel central na deteção de ataques de fraude em escala global, impedindo a expansão de redes complexas de lavagem de dinheiro e monitorizando o risco financeiro de ponta a ponta.

Inteligência Artificial: Aplicações, Implicações e Especulações

A Inteligência Artificial impõe-se cada vez mais na realidade das sociedades contemporâneas. Novos desenvolvimentos tecnológicos nascem todos os dias mas raramente o seu impacto é devidamente reflectido na esfera pública. Assumindo a importância de conhecer e discutir esta realidade, este ciclo de debates promove o olhar e a reflexão sobre as aplicações atuais da Inteligência Artificial, as suas implicações sociais nas mais variadas dimensões (da saúde à privacidade, à empregabilidade e outras) e a forma como se imagina o futuro neste novo paradigma.

Entre abril e junho, o ciclo divide-se em três momentos, cada um com um programa duplo: um debate com vários oradores do meio académico e empresarial e uma grande conferência.

17 ABR QUA

16:00 APLICAÇÕES

18:30 APLICAÇÕES (AS BOAS E AS MÁS) com Mário Figueiredo

15 MAI QUA

16:00 IMPLICAÇÕES

18:30 A ASCENSÃO DOS ROBÔS com Martin Ford

05 JUN QUA

16:00 ESPECULAÇÕES

18:30 INTELIGÊNCIA ARTIFICIAL HUMANO COMPATÍVEL com Stuart Russell

PARCERIA

Fidelidade - Companhia de Seguros

Culturgest

PARCERIA CIENTÍFICA

Instituto Superior Técnico da Universidade de Lisboa

CONSULTORES CIENTÍFICOS

Arlindo Oliveira (IST), Ana Paiva (IST), Mário Figueiredo (IST)

CURADORIA

Arlindo Oliveira, Ana Paiva, Liliana Coutinho, Mário Figueiredo

Integrado na Bienal BoCA

MILLIND TAMBE

Professor Helen N. e Emmett H. Jones de Engenharia na Universidade do Sul da Califórnia (USC),

Codiretor e Fundador do CAIS, Centro de Inteligência Artificial / USC

LUÍSA COHEUR

Professora do Departamento de Engenharia Informática do IST e investigadora no INESC-ID

PEDRO BIZARRO

Cofundador e Chief Science Officer da Feedzai

Moderação:

INÊS LYNCE (IST)